WordPress网站robots.txt怎么写?robots.txt是网站很重要的一个组成部分。它告诉搜索引擎什么文件可以抓取,什么文件不能抓取。它是搜索引擎和网站之间一个默许的协议,由搜索引擎自觉遵守,用文本文档来实现,放在robots.txt中。很多新手只知道服务器运维、建设wordpress网站内容、发外链、加友链,却不知道在网站建设初期及正常上线后最重要的robots.txt文件,所以对新手来说,本文内容很重要,建议大家好好看看,这里面有魏艾斯博客自己的体会。

曾经遇到网友问:阿里云oss和阿里云cdn 需要添加robots.txt吗?其实robot文件服务于网站,只存在于网站根目录,与oss、cdn等都没有关系。

一、robot文件怎么写?

最简单的写法是如下面例子的两行代码。

下面两行代码表示网站禁止抓取(*和/前面要有一个空格)

User-agent: *

Disallow: /

下面代码表示网站开放抓取

User-agent: *

Allow:

当robots.txt为空的时候,代表允许任何搜索引擎抓取,没有限制。

1、如果你是新建网站,在安装完wordpress程序之后,应该立即使用上面的禁止抓取代码。等待网站安装、配置完毕,发布一定内容之后,这时确认网站形式、目录架构、核心方向、内容模式不会有删改之后,再开放抓取,这样能够让搜索引擎抓取到正确的内容。

老魏提示:一定要在开放抓取之前搞定网站相关内容,开放抓取之后只是新增内容、目录,这都是正常的。如果再删、改就会引起搜索引擎的反感,进而可能会被惩罚。

如果不放置这个robots.txt文件,从零开始对wordpress网站内容、目录、结构反复多次增、删、改,只会让搜索引擎认为你的网站不稳定,造成抓取了也不放出来,放出来也不给权重,不给好的排名,不给关键词靠前等等不良后果。

说到底大部分网站都是靠着搜索引擎的青睐才能活下去,我们做不到独特内容让搜索引擎特别喜欢你,起码也别被搜索引擎反感。

2、Avada网站因为模板中用的代码太多,建议使用开放抓取代码,以便加速搜索引擎抓取你的网站。

3、老魏写的时候会参考一下同行业内排名较好的网站,看看他们是怎么写的,有哪些地方我也能用到,就直接copy过来咯。然后结合这个网站的实际情况,总结后写出属于自己的那个robot文件。

老魏提示:要找到你所在那个行业排名较好的前几名,获取到他们的robot文件,结合自己的实际情况改写下,就很容易写出来了。

4、根据老魏的经验,robot结尾一定要带上sitemap文件,这也是给搜索引擎抓取用的。引导蜘蛛跟着sitemap的路径会遍历网站内容,有助于加快抓取速度和遍历深度。

参考文章:Google XML Sitemaps 及相关设置过程

5、外贸网站屏蔽国内搜索引擎,可以这么写:

User-agent: Baiduspider

Disallow: /

User-agent: baiduspider

Disallow: /

以上是淘宝网屏蔽百度蜘蛛的代码,大家可以参考下,下面用几个常见情况举例说明:

允许所有SE收录本站:

robots.txt为空,什么都不要写。

禁止所有搜索引擎抓取网站特定目录:

User-agent: *

Disallow: /目录名1/

Disallow: /目录名2/

Disallow: /目录名3/

禁止某个搜索引擎抓取本站,比如禁止百度:

User-agent: Baiduspider

Disallow: /

禁止所有搜索引擎抓取本站:

User-agent: *

Disallow: /

写好了之后放到网站根目录,比如wordpress网站的话,就用ftp软件上传到wp-admin、wp-content、wp-includes文件夹同一级目录即可。

比如魏艾斯博客的robot文件网址是 https://www.vpsss.net/robots.txt,你传上去之后把域名用你自己的替换掉,用网址能正常打开看到内容就说明是正确的了。

三、robot的一点个人经验总结

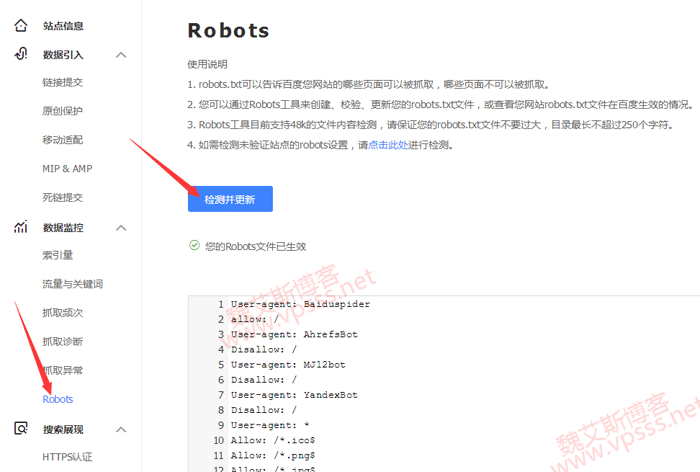

1、robots文件的官方写法,国内请参考百度搜索资源平台>站点管理>数据监控>Robots。下面有一些关于写法的一些解释,如果你的网站主要靠百度带来流量,就老老实实的依照建议写。

我们常用的就是allow、Disallow等几条命令,allow也就是允许抓取文件、文件夹;Disallow是禁止抓取文件、文件夹。

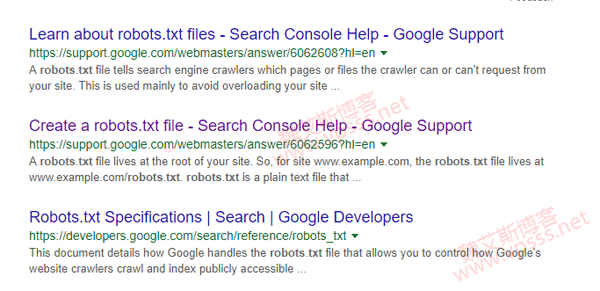

2、外贸站及面向国外访客的网站,robot写法请参考google support中心的解释,因为国外网站的流量主要来源自谷歌,按照谷歌爸爸的描述去操作准没错。

怎么找到谷歌爸爸的官方说法呢?你去打开谷歌搜索,输入 robots.txt 搜索一下,结果中就能看到如下图的谷歌support中心提供的相关描述了。

3、禁止了robot之后,搜索引擎会按照相应的规则抓取或不抓取网站内容。不过用户是可以正常访问网站的。

robots.txt文件的写法还有一些,是根据你个人的具体情况写出来的,怎么写的技巧上面老魏已经提到过了,大家可以参考老魏的或者你所在行业中翘楚的综合起来写。老魏这是用在wordpress网站中的,大家可别用错了哦。

暂无评论内容